https://www.datamanim.com/dataset/03_dataq/typeone.html#id6

작업 1유형 — DataManim

Question 각 비디오는 10분 간격으로 구독자수, 좋아요, 싫어요수, 댓글수가 수집된것으로 알려졌다. 공범 EP1의 비디오정보 데이터중 수집간격이 5분 이하, 20분이상인 데이터 구간( 해당 시점 전,후

www.datamanim.com

Question

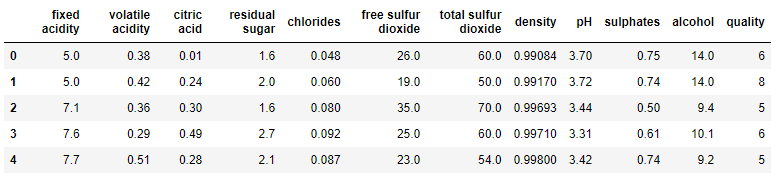

quality 값이 3인 그룹과 8인 데이터그룹의 각 컬럼별 독립변수의 표준편차 값의 차이를 구할때 그값이 가장 큰 컬럼명을 구하여라

import pandas as pd

df = pd.read_csv("https://raw.githubusercontent.com/Datamanim/datarepo/main/redwine/train.csv")

df.head()

answer = (df.loc[df.quality ==8].std() -df.loc[df.quality ==3].std()).sort_values().index[-1]

print(answer)

'빅데이터분석기사 > 작업 1유형' 카테고리의 다른 글

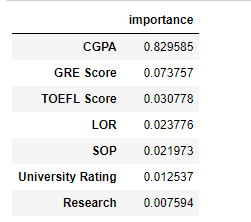

| 대학원 입학가능성 데이터 (0) | 2022.08.15 |

|---|---|

| 킹카운티 주거지 가격 예측 문제 데이터 (0) | 2022.08.15 |

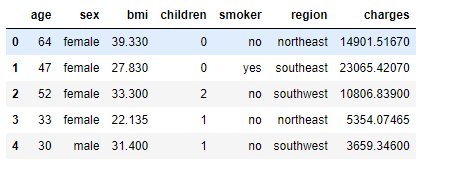

| 의료 비용 예측 데이터 (0) | 2022.08.15 |

| 수질 음용성 여부 데이터 (0) | 2022.08.15 |

| 비행 탑승 경험 만족도 데이터 (0) | 2022.08.15 |